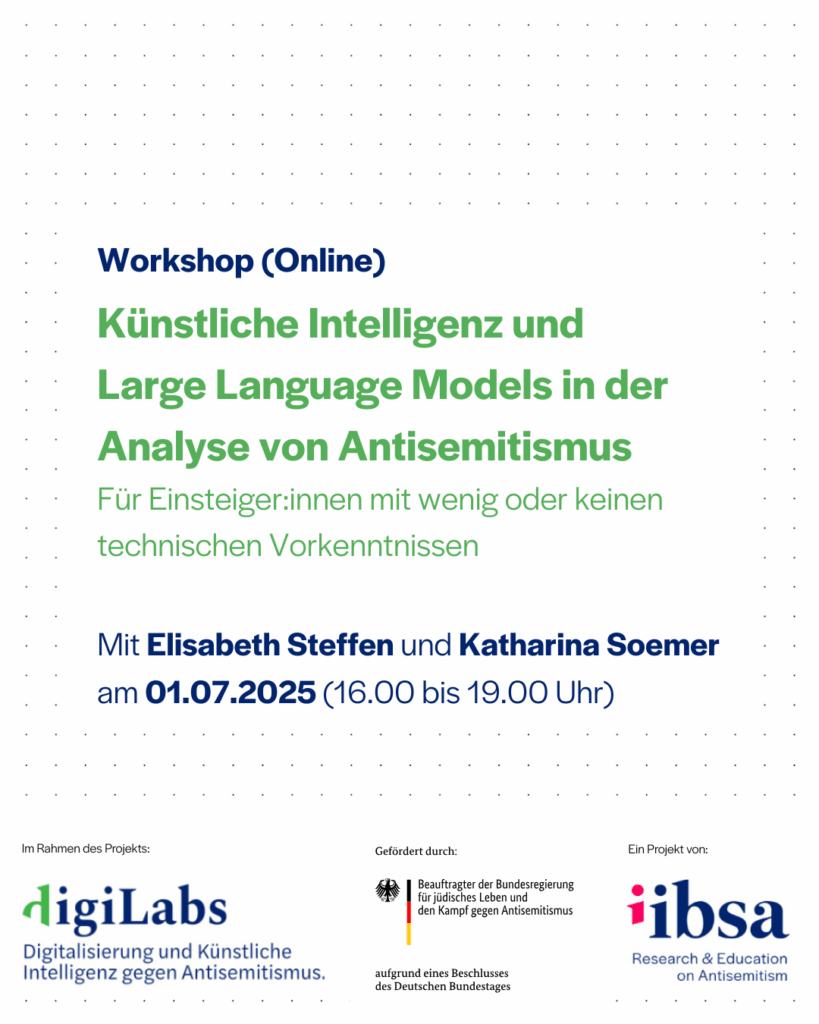

Workshop: Künstliche Intelligenz und Large Language Models in der Analyse von Antisemitismus

Für Einsteiger:innen mit wenig oder keinen technischen Vorkenntnissen

01. Juli 2025, 17:00-20:00 Uhr (online)

Angesichts der zunehmenden Verbreitung antisemitischer Ideologien – unter anderem in Form von Hassrede, Gewaltaufrufen und Verschwörungstheorien – in sozialen Medien wird der Einsatz technologischer Mittel zur Erkennung und Analyse dieser Phänomene immer wichtiger. Während KI-basierte Verfahren zur automatischen Erkennung von Hate Speech erhebliche Fortschritte gemacht haben, stellt die Identifikation antisemitischer Inhalte nach wie vor eine besondere Herausforderung dar – insbesondere bei kodierten oder kontextabhängigen Ausdrucksformen.

Der Workshop bietet eine praxisnahe Einführung in die KI-gestützte Textklassifikation antisemitischer Inhalte. Anhand konkreter Beispiele aus sozialen Medien werden Potenziale und Grenzen verschiedener Ansätze diskutiert – vom klassischen Supervised Learning bis hin zu modernen Prompt-basierten Methoden mit Large Language Models (LLMs).

Der Workshop richtet sich an Einsteiger:innen mit wenig oder keinen technischen Vorkenntnissen. Programmiersprache ist Python. Vorkenntnisse über Antisemitismus und seine Erscheinungsformen sind hilfreich, aber nicht notwendig.

Der Workshop findet im Rahmen des Projekts DigiLabs – Digitalisierung und Künstliche Intelligenz gegen Antisemitismus statt und wird vom Internationalen Institut für Bildung, Sozial- und Antisemitismusforschung (IIBSA) veranstaltet. Das Projekt wird vom Beauftragten der Bundesregierung für jüdisches Leben und den Kampf gegen Antisemitismus gefördert.

Link zur Anmeldung: Hier klicken (Teilnehmendenzahl ist begrenzt)

Ablauf:

Block 1: Einführung & Kontext

– Warum KI zur Analyse von Antisemitismus?

– Besonderheiten antisemitischer Online-Diskurse

– Herausforderungen bei der automatisierten Erkennung von Antisemitismus

Block 2: Grundlagen der Sprachverarbeitung mit KI

– Was ist NLP (Natural Language Processing)?

– Wichtige Begriffe wie Tokenisierung, Word Embeddings, Sprachmodelle

– Einführung in Large Language Models (z. B. GPT, BERT etc.)

Block 3: Von Daten zum Modell: (Automatische) Textklassifikation

– Was ist manuelle Annotation, und wie müssen Daten aufbereitet werden?

– Wie funktioniert Supervised Learning?

– Was sind Evaluationsmetriken? (Precision, Recall, F1-Score)

Block 4: Neuere Ansätze mit LLMs

– Prompt-basierte Klassifikation (Zero-Shot, Few-Shot)

– Möglichkeiten & Grenzen: Output-Kontrolle, Halluzinationen, Bias

Block 5: Diskussion & Ausblick

– Reflexion: Was kann KI leisten – und was nicht?

– Austausch & Fragen

Elisabeth Steffen ist wissenschaftliche Mitarbeiterin und Doktorandin an der TU Berlin und der HTW Berlin. Ihre Forschung verbindet Kulturwissenschaft mit Data Science und fokussiert auf Verschwörungstheorien und Antisemitismus in digitalen Räumen. In ihrer Dissertation beschäftigt sie sich mit multimodalen Analysen von Verschwörungsideologien in sozialen Medien. Sie hat Abschlüsse in Informatik und Wirtschaft (B.Sc., Hochschule für Technik und Wirtschaft Berlin), Sozial- und Kulturanthropologie (B.A., Freie Universität Berlin) sowie Europäischer Ethnologie (M.A., Humboldt Universität zu Berlin).

Katharina Soemer ist wissenschaftliche Mitarbeiterin an der Professur für Quantitative Analysen gesellschaftlichen Wandels am Institut für Soziologie der Goethe-Universität Frankfurt und promoviert an der Universität Hildesheim im Fach Informationswissenschaften zu methodischen Grundlagen für die automatische Erkennung von Antisemitismus und Hate Speech in sozialen Medien mit einem Fokus auf Fragen zu Sampling und Annotation. Sie hat Soziologie (B.A.), Soziologie und Sozialforschung (M.A.) und Informatik (ohne Abschluss) in Bremen und Lissabon studiert.